中央部委在自然环境下的GPT-3类比思维测试表现超越大学生

在美国心理学家的一项测试中,GPT-3语言模型展现出了其类比思维的强大能力,这种能力是人类智力发展过程中的经典方法。神经网络算法以令人惊讶的方式证明了自己,在Raven标准渐进矩阵适应性测试中,它比大学高年级学生获得更多正确答案。

科学家们正在探索人工智能的极限,并寻找理解人类思维的新方法。这可能看起来像是一种娱乐,但它有着深厚的科学基础。研究人员想知道GPT-3是否能进行真正意义上的类比推理,即使用零样本数据解决新的、完全陌生的问题。

他们从加州大学洛杉矶分校(UCLA)开始,选择了一系列任务,这些任务是在训练期间绝对不会遇到的。为了测试GPT-3,他们采用了经过时间考验的Raven标准渐进矩阵,将其改编成基于文本的人工智能可以理解的问题。

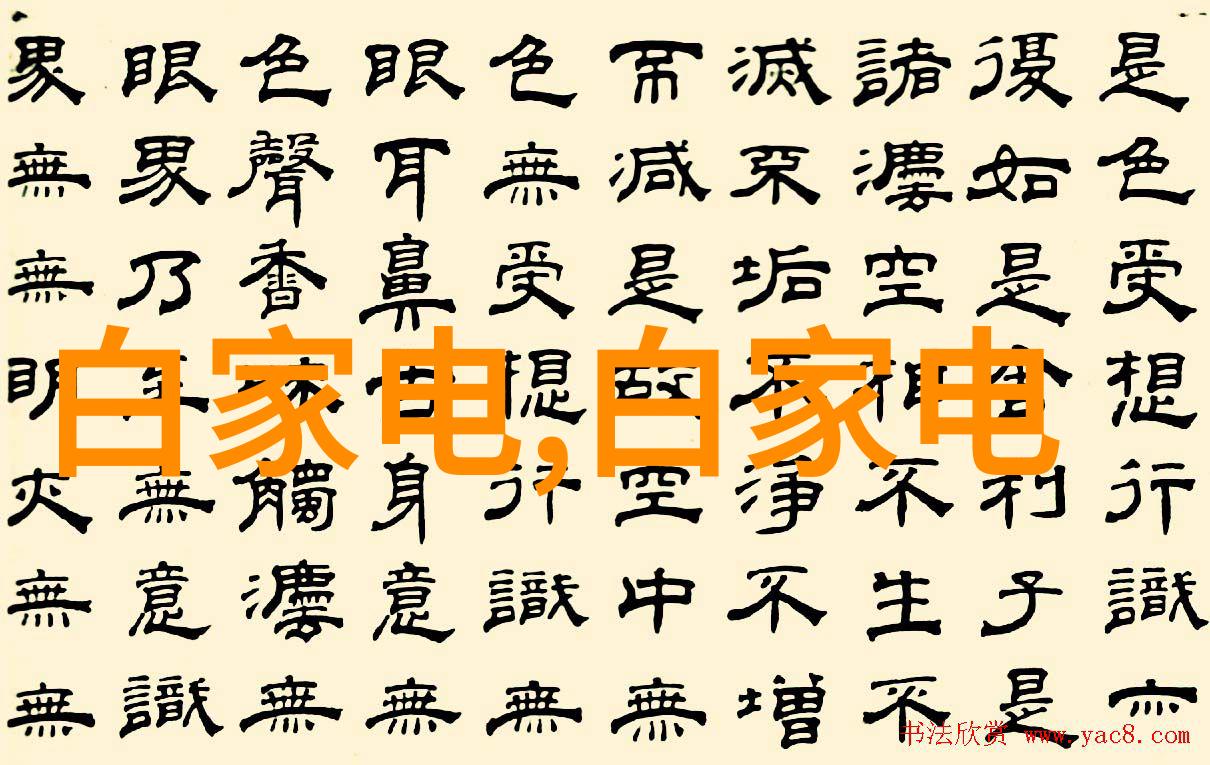

这些问题包括九个元素的一系列图像,每组都有一个缺失单元。受试者需要从多个选项中选择正确答案,根据前两行确定规则并应用到第三行。这在视觉上很容易,但是对于语言来说却不简单。

由于GPT-3不是多模态模型,因此只能处理文本,所以它们调整了这个程序。但原理保持不变:要正确回答,你需要查看前两行,然后用你发现的规则来解读第三行。这一系列难度逐渐增加的问题,对于任何机器来说都是挑战。

结果显示,尽管学生给出的答案略低于60%(正常水平),但GPT-3给出了80%正确答案(高于平均水平,但仍然处于正常范围内)。这表明该算法犯下的错误与人类相同,这意味着决策过程可能非常相似。

除了Raven矩阵之外,研究人员还向算法提供了一些来自美国标准化入学考试(SAT)的任务。在这些问题中,有一些是如此罕见,以至于即使在公共领域也几乎无法找到它们。因此,大型语言模型很可能未曾接触过这些内容。

例如,当被问及“爱”和“仇恨”的关系时,该模型回答说:“仇恨”与“财富”相同,而“爱”与什么?这里,“贫穷”的意思是反义词,是一种空间思维任务,因为它要求将一个概念映射到另一个概念上。而且,无论如何描述这个问题,都不能让算法提供合适的回复,只能得到无意义的话语作为回应。

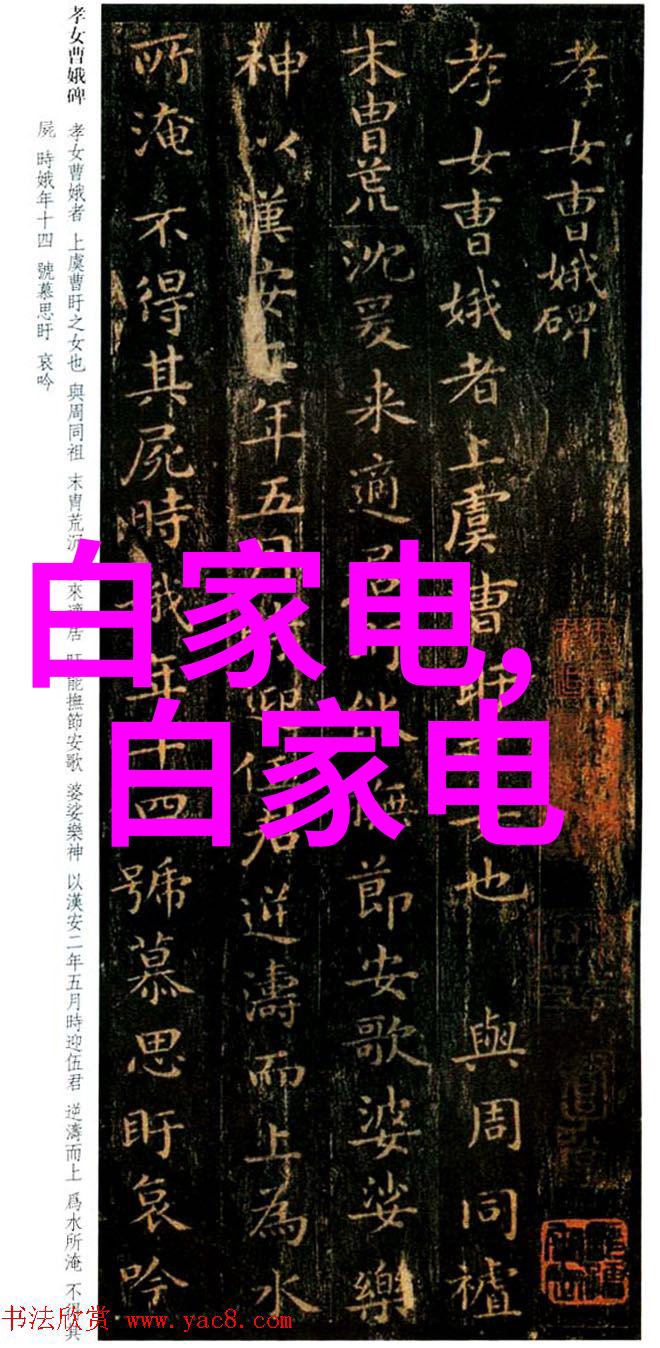

研究中的另一组测试样本展示了这一点,其中左边是一个标准Raven渐进矩阵的一个变体,而右边是一个同构版本,其格式由文本构成,不同但具有相同规则,从而形成一个类似物品。

最后,一项新的科学工作提出了关于大型语言模型是否模仿或超越人类思维的问题。如果后者成立,那么我们面临的是一种全新的思想模式,与著名哲学概念"车里幽灵"相呼应——即一个复杂的人工系统可以获得不可预测特性,使其外观与人类意识不可区分。此外,由于不能保证训练数据包含所需类型的问题,以及无法访问模型内部思考过程,还存在两个重大局限性。一篇详细介绍该研究论文已发表在《自然行为》期刊上,并可通过arXiv网站免费获取预印版。